王兴刚导师AI知识讲座——Mamba架构简介

王兴刚导师AI知识讲座——Mamba架构简介

文| 798号队员 李永康

2024年4月21日晚7点,团队兼职导师,D207号老队员王兴刚老师受团队在站队员邀请,特地回团队进行AI知识讲座——Mamba架构简介。王兴刚老师是计算机视觉领域知名青年学者,担任领域内权威期刊主编,曾获微软学者、吴文俊人工智能优秀青年奖等荣誉。本次分享活动过程中,王兴刚老师主要对最近备受瞩目的“Mamba”架构进行了讲解。此次讲座活动提供了同步直播渠道供其他老队员线上参与。

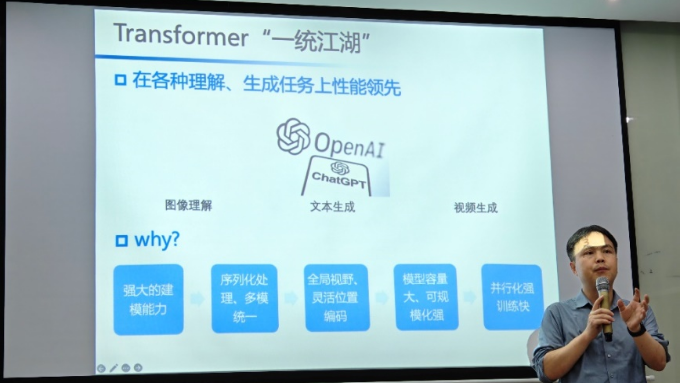

图1 王兴刚老师讲解Transformer架构

王兴刚老师首先从Transformer架构讲起,自《Attention Is All You Need》发表后,Transformer架构因其强大的建模能力、多模态的统一、全局视野以及模型容量大等特点,统一了各种理解和生成任务。

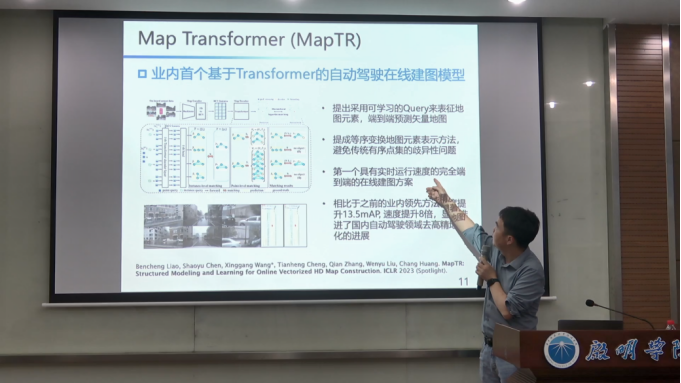

随后,王老师介绍了实验室的Transformer相关工作,D510号队员黄子龙和王老师提出了计算机视觉领域首个稀疏自注意力方法,该机制是谷歌DeepMind的蛋白质解译智能系统AlphaFold(《Nature》封面文章)的核心组件;EVA基于大规模掩码学习的视觉大模型,是世界上首个开源的、性能领先的10亿参数视觉基础大模型;D654号队员廖本成和王老师提出的MapTR,是业内首个基于Transformer的自动驾驶在线建图模型,显著提高了国内自动驾驶领域去高精地图化的发展。

图2 D654号队员廖本成和王兴刚老师提出的MapTR在线建图模型

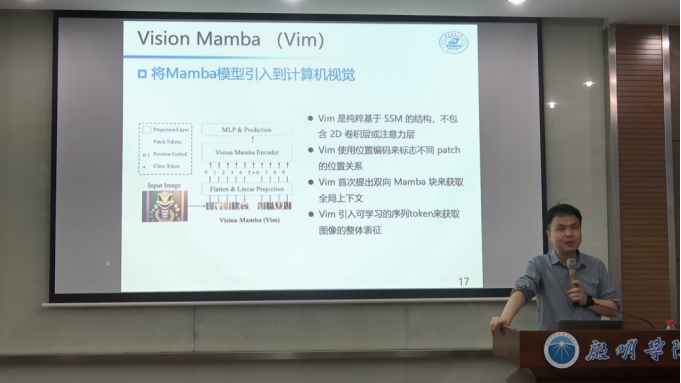

王兴刚老师接着指出了Transformer架构的局限性,比如解决长序列问题计算复杂度高等问题,并引出了最新横空初始的“Mamba”——一种低复杂度序列建模的架构。团队D676号队员朱良辉和D654号队员廖本成共同一作提出的Vision Mamba是首个将“Mamba”引入视觉领域的工作,王老师对Vision Mamba的算法细节做了详细的讲解,Vim相比于Vit等Transformer架构的模型,精度更优,同时更加高效,包括后面基于Mamba架构的相关工作都使用了Vim相关模块,展望未来,王兴刚老师认为Vision Mamba具有成为下一代视觉表征学习骨干网络的潜力,在视觉相关任务上具有显著的推理速度和内存使用优势。同时,长序列表征学习在Sora视频生成、多模态大模型领域非常重要,探索类似Mamba的低复杂度序列建模网络是非常重要的问题。但同时Mamba模型仍存在一些挑战,如缺乏超大规模预训练的验证,缺乏灵活的多模态自监督方法等。

图3 D676号队员朱良辉和D654号队员廖本成提出的Vision Mamba工作

王兴刚导师的精彩分享让在场的导师和队员们受益匪浅,其中许多开创性工作均是王老师指导多位Dian团队的年轻队员们在研究生博士阶段完成,这很好地体现了Dian团队科研血脉的传承和发展。